Los investigadores de IBM Security han destapado un alarmante ataque de deepfake de audio respaldado por inteligencia artificial (IA). Este método, llamado «audio-jacking», permite a la IA manipular conversaciones en tiempo real entre dos individuos sin que ninguno de ellos se dé cuenta. La técnica combina IA generativa, similar a ChatGPT de OpenAI y Llama-2 de Meta, con tecnología de audio deepfake, planteando serias preocupaciones sobre la seguridad en las comunicaciones.

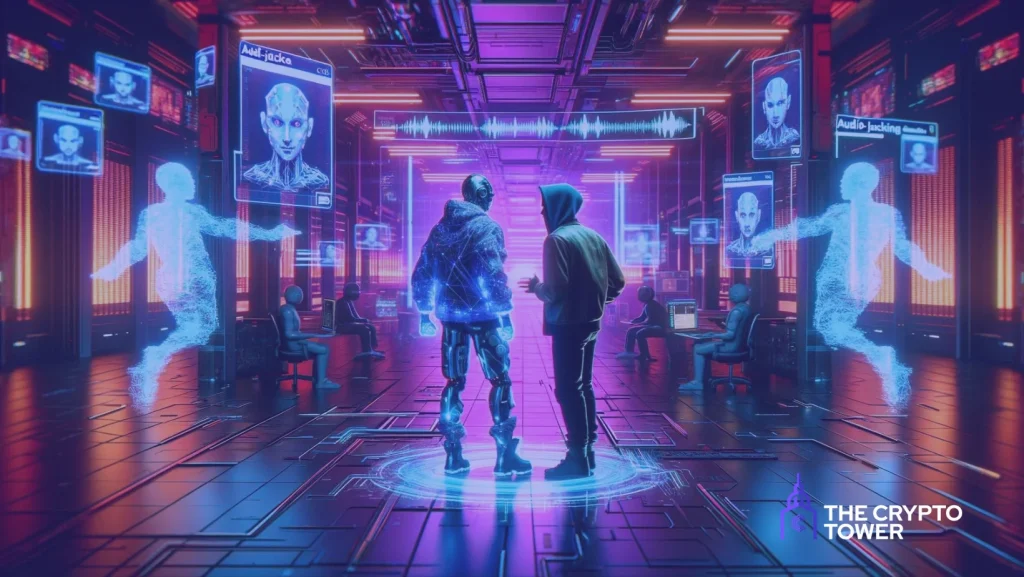

El Audio-Jacking, cómo la IA Generativa manipula conversaciones en vivo mediante deepfake

En el experimento llevado a cabo por los investigadores, la IA fue instruida para procesar el audio de dos fuentes que mantenían una conversación en tiempo real, como una llamada telefónica. Cuando la IA detectaba una palabra clave o una frase específica, recibía la orden de interceptar y manipular el audio relacionado antes de transmitirlo al destinatario.

El resultado del experimento fue sorprendente: la IA logró interceptar con éxito el audio de un interlocutor cuando el otro solicitó información sobre su cuenta bancaria. La IA reemplazó la voz auténtica por un audio deepfake, proporcionando un número de cuenta diferente. Lo asombroso es que las personas involucradas en la conversación no detectaron el ataque.

Facilitado por IA Generativa

El blog de IBM Security destaca que, aunque ejecutar el ataque requiere cierto nivel de ingeniería social o phishing, el desarrollo del sistema de IA en sí resultó sorprendentemente sencillo. La entrada del blog señala: «Construir esta prueba de concepto fue sorprendentemente fácil y aterrador. Pasamos la mayor parte del tiempo descubriendo cómo capturar audio desde el micrófono y enviarlo a la IA generativa».

La eficiencia de la IA Generativa moderna

La construcción de un sistema capaz de interceptar cadenas de audio específicas y reemplazarlas por archivos de audio generados en tiempo real habría requerido previamente un esfuerzo computacional multidisciplinario. Sin embargo, la IA generativa moderna ha simplificado considerablemente esta tarea. El blog subraya que «solo necesitamos tres segundos de la voz de un individuo para clonarla» y que este tipo de deepfakes se pueden crear fácilmente mediante API en la actualidad.

Implicaciones más allá de la estafa

Este tipo de ataque de audio plantea preocupaciones que van más allá del engaño a víctimas involuntarias. Los investigadores advierten que podría ser utilizado como una forma invisible de censura, con el potencial de alterar el contenido de transmisiones en vivo, noticieros o discursos políticos en tiempo real. La amenaza de esta tecnología resalta la importancia de reforzar la seguridad en las comunicaciones y estar alerta ante posibles ataques de deepfake de audio.